(一)Spark简介-Java&Python版Spark

Spark简介

视频教程:

1、优酷

2、YouTube

简介:

Spark是加州大学伯克利分校AMP实验室,开发的通用内存并行计算框架。Spark在2013年6月进入Apache成为孵化项目,8个月后成为Apache顶级项目Spark以其先进的设计理念,迅速成为社区的热门项目,围绕着Spark推出了Spark SQL、Spark Streaming、MLLib和GraphX等组件,也就是BDAS(伯克利数据分析栈),这些组件逐渐形成大数据处理一站式解决平台。

Spark使用Scala语言实现,它是一种面向对象、函数式编程语言,能够像操作本地集合对象一样轻松的操作分布式数据集。

Spark特点:

1、运行速度快

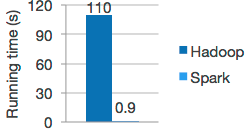

Spark拥有DAG执行引擎,支持在内存中对数据进行迭代计算。官方提供的数据表明,如果数据由磁盘读取,速度是Hadoop MapReduce的10倍以上,如果数据从内存中读取,速度可以高达100多倍。

2、易用性好

Spark不仅支持Scala编写应用程序,而且支持Java和Python等语言进行编写,特别是Scala是一种高效、可拓展的语言,能够用简洁的代码处理较为复杂的处理工作。

3、通用性强

Spark生态圈即BDAS(伯克利数据分析栈)包含了Spark Core、Spark SQL、SparkStreaming、MLLib和GraphX等组件,这些组件分别处理:Spark Core提供内存计算框架、SparkStreaming的实时处理应用、Spark SQL的即时查询、MLlib的机器学习和GraphX的图处理,它们都是由AMP实验室提供,能够无缝的集成并提供一站式解决平台。

4、随处运行

Spark具有很强的适应性,能够读取HDFS、Cassandra、HBase、S3为持久层读写原生数据,能够以Mesos、YARN和自身携带的Standalone作为资源管理器调度job,来完成Spark应用程序的计算。

Spark与Hadoop的对比(Spark的优势)

1、Spark的中间数据放到内存中,对于迭代运算效率更高

2、Spark比Hadoop更通用

3、Spark提供了统一的编程接口

4、容错性– 在分布式数据集计算时通过checkpoint来实现容错

5、可用性– Spark通过提供丰富的Scala, Java,Python API及交互式Shell来提高可用性

1、目前大数据处理场景

1. 复杂的批量处理(Batch Data Processing),偏重点在于处理海量数据的能力,至于处理速度可忍受,通常的时间可能是在数十分钟到数小时;

2. 基于历史数据的交互式查询(Interactive Query),通常的时间在数十秒到数十分钟之间

3. 基于实时数据流的数据处理(Streaming Data Processing),通常在数百毫秒到数秒之间

2、以上三种场景都有比较成熟的处理框架

1————————Hadoop的MapReduce来进行海量数据的批处理

2————————Impala进行交互式查询

3————————Storm分布式处理框架处理实时流式数据

3、总结:

1、Spark是基于内存的迭代计算框架,适用于需要多次操作特定数据集的应用场合。需要反复操作的次数越多,所需读取的数据量越大,受益越大,数据量小但是计算密集度较大的场合,受益就相对较小。

2、由于RDD的特性,Spark不适用那种异步细粒度更新状态的应用,例如web服务的存储或者是增量的web爬虫和索引。就是对于那种增量修改的应用模型不适合。

3、数据量不是特别大,但是要求实时统计分析需求。

Spark成功案例:

1、腾讯

广点通是最早使用Spark的应用之一。腾讯大数据精准推荐借助Spark快速迭代的优势,围绕“数据+算法+系统”这套技术方案,实现了在“数据实时采集、算法实时训练、系统实时预测”的全流程实时并行高维算法,最终成功应用于广点通投放系统上,支持每天上百亿的请求量。

2、Yahoo

Yahoo将Spark用在Audience Expansion中的应用。Audience Expansion是广告中寻找目标用户的一种方法:首先广告者提供一些观看了广告并且购买产品的样本客户,据此进行

学习,寻找更多可能转化的用户,对他们定向广告。Yahoo采用的算法是logistic regression。目前在Yahoo部署的Spark集群有112台节点,9.2TB内存。

3、淘宝

阿里搜索和广告业务,最初使用Mahout或者自己写的MR来解决复杂的机器学习,导致效率低而且代码不易维护。淘宝技术团队使用了Spark来解决多次迭代的机器学习算法、高计算复杂度的算法等。将Spark运用于淘宝的推荐相关算法上,同时还利用Graphx解决了许多生产问题,包括:基于度分布的中枢节点发现、基于最大连通图的社区发现、基于三角形计数的关系衡量、基于随机游走的用户属性传播等。

Spark运行模式:

|

Local |

本地模式 |

用于本地开发测试,本地还分为local单线程和local-cluster多线程。 |

|

On yarn |

集群模式 |

运行在yarn框架之上,由yarn负责资源管理,Spark负责任务调度和计算。 |

|

Standalone |

集群模式 |

典型的Mater-slave模式,Spark自带的模式。 |

Concepts:

Application:

Spark Application的概念和Hadoop MapReduce类似,指的是用户编写的Spark应用程序,包含了一个Driver 功能的代码和分布在集群中多个节点上运行的Executor代码。

Driver:

Spark中的Driver即运行上述Application的main()函数并且创建SparkContext,其中创建SparkContext的目的是为了准备Spark应用程序的运行环境。在Spark中由SparkContext负责和ClusterManager通信,进行资源的申请、任务的分配和监控等;当Executor部分运行完毕后,Driver负责将SparkContext关闭。通常用SparkContext代表Drive。

Executor:

Application运行在Worker 节点上的一个进程,该进程负责运行Task,并且负责将数据存在内存或者磁盘上,每个Application都有各自独立的一批Executor。在Spark on Yarn模式下,其进程名称为CoarseGrainedExecutorBackend,类似于Hadoop MapReduce中的YarnChild。一个CoarseGrainedExecutorBackend进程有且仅有一个executor对象,它负责将Task包装成taskRunner,并从线程池中抽取出一个空闲线程运行Task。每个CoarseGrainedExecutorBackend能并行运行Task的数量就取决于分配给它的CPU的个数了。

Cluster Manager:

指的是在集群上获取资源的外部服务,目前有:Standalone、Mesos、Yarn

Worker:

集群中任何可以运行Application代码的节点,类似于YARN中的NodeManager节点。在Standalone模式中指的就是通过Slave文件配置的Worker节点,在Spark on Yarn模式中指的就是NodeManager节点。

作业(Job):

包含多个Task组成的并行计算,往往由Spark Action催生,一个JOB包含多个RDD及作用于相应RDD上的各种Operation。

阶段(Stage):

每个Job会被拆分很多组Task,每组任务被称为Stage,也可称TaskSet,一个作业分为多个阶段。

任务(Task):

被送到某个Executor上的工作任务。

RDD(*):

是Resilient distributed datasets的简称,中文为弹性分布式数据集;是Spark最核心的模块和类。

DAGScheduler:

根据Job构建基于Stage的DAG,并提交Stage给TaskScheduler。

TaskScheduler:

将Taskset提交给Worker node集群运行并返回结果。

Transformations:

是Spark API的一种类型,Transformation返回值还是一个RDD, 所有的Transformation采用的都是懒策略,如果只是将Transformation提交是不会执行计算的。

Action:

转发申明:

本文转自互联网,由小站整理并发布,在于分享相关技术和知识。版权归原作者所有,如有侵权,请联系本站 top8488@163.com,将在24小时内删除。谢谢